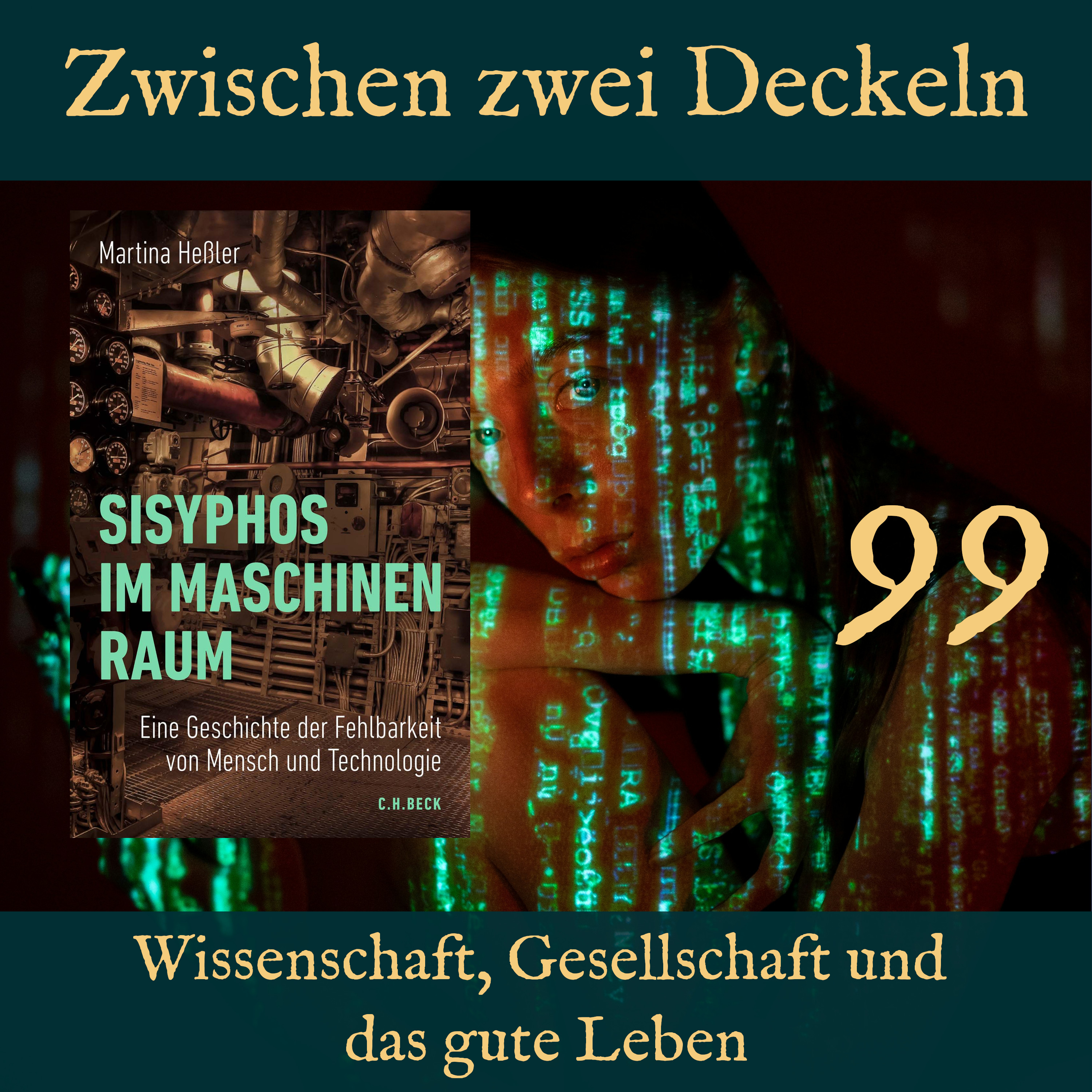

Martina Heßler erzählt in „Sisyphos im Maschinenraum“ die Geschichte einer Doppelfigur. Auf der einen Seite steht der im Vergleich zur Technik fehlerhafte Mensch und auf der anderen Seite sein Pendant, die vermeintlich perfekte Maschine. Auch wenn sich letztere letztlich nicht als fehlerfreies, technologisch errichtetes Paradies erwies, sondern als permanente Aufgabe. Mit der zunehmenden Komplexität der Technik erodierte dann auch, insbesondere seit den 1970er Jahren und durch die heutige Künstliche Intelligenz, das Bild der unfehlbaren Maschine.

Shownotes- Buch: „The Triumph of Injustice“ von Emmanuel Saez und Gabriel Zucman

- Buch: „Sisyphos im Maschinenraum“ von Martina Heßler

- Artikel: „Zur Persistenz der Argumente im Automatisierungsdiskurs“ von Martina Heßler bei der Bundeszentrale für politische Bildung

- ZZD095: „Vertrauensfragen“ von Ute Frevert

- YouTube: „Die Maus“

- Artikel: „Manufaktur“ bei der Bundeszentrale für politische Bildung

- Film: „Dr. Seltsam oder wie ich lernte, die Bombe zu lernen“ von Stanley Kubrick

- ZZD021: „Moderne und Ambivalenz“ von Zygmunt Bauman

- Wikipedia: „Jahr-2000-Problem/Millenium-Bug“

- Artikel: „Triviale und nicht-triviale Maschinen“ von Michael Michaelis

- ZZD078: „Der Code des Kapitals“ von Katharina Pistor

- Podcastfolge: Armin Maiwald bei „Alles gesagt?“ von der ZEIT

- Buch: „Fooled by Randomness“ von Nassim Nicholas Taleb

- ZZD088: „Das Auge des Meisters“ von Matteo Pasquinelli

- ZZD058: „Merchants of Doubt“ von Naomi Oreskes und Erik M. Conway

- ZZD049: „The Collapse Of Chaos“ von Ian Stewart und Jack Cohen

- Artikel: „Deutsche Bank warnt: Nur KI-Blase hält US-Wirtschaft noch zusammen“ auf golem.de

- Buch: „Der Anfang von Himmel und Erde hat keinen Namen“ von Heinz von Foerster

- Artikel: „On the Dangers of Stochastic Parrots: Can Lagnuage Models Be Too Big? “ von Emily M. Bender et al.

- Artikel: „Warum hat Albanien eine KI als Ministerin?“, auf tagesschau.de

- ZZD037: „Im Wald vor lauter Bäumen“ von Dirk Brockmann

Music:

[0:00] Music

Holger:

[0:15] Herzlich willkommen zu Folge 99 von Zwischenzweideckeln. Ich bin Holger und ich höre heute dem Christoph zu.

Christoph:

[0:24] Hallo zusammen.

Holger:

[0:26] Wie geht’s dir, Christoph?

Christoph:

[0:29] Gut soweit, danke. Ich freue mich ehrlicherweise auf den Herbst, der jetzt ja so langsam kommt. Ich mag die Jahreszeit sehr gerne und genieße das, dass es ein bisschen kühler

Christoph:

[0:40] wird, die morgen da angenehm knackig sind. Das finde ich alles sehr gut. Wie ist es bei dir?

Holger:

[0:46] Ja, also mir geht es auch gut Leichte Sportverletzung von gestern, aber nichts Ernstes, Ich muss gestehen, ich mag auch den Herbst was lieber als so den heißen Sommer, stell mir jetzt gerade die Frage ob das irgendwie bei Bücherfans häufig so ist.

Christoph:

[1:04] Gute Frage Ja, ich habe auf jeden Fall romantisierte Vorstellungen von auf dem Sofa liegen mit einem Tee und einem Buch, also ja das würde in die Kerbe schlagen Ja,

Holger:

[1:15] Wie oft man das dann wirklich schafft, ist eine andere Frage, aber in der Theorie. Genau. Was beschäftigt dich denn im Moment?

Christoph:

[1:28] Mich beschäftigt mein Ausflug in gut zwei Wochen in die Normandie. Ich möchte nochmal, ich werde das erste Mal alleine Urlaub machen, das habe ich noch nie gemacht und ich gehe ein paar Tage wandern. Und ich würde ja immer denken, dass man in den Weiten des Internets jede Information zu jedem Wanderweg, vor allen Dingen zu Wanderwegen, die irgendwelche Preise gewonnen haben, irgendwann findet, wie die Etappen genau verlaufen, welche Varianten es so gibt und so und das ist bei dem Wanderweg nicht der Fall, beziehungsweise es ist sehr viel auf Französisch und mein Französisch ist nicht so gut und ehrlicherweise, damit sind wir dann auch schon halb beim Thema unserer Episodensammlung hier momentan, unseres kleinen Inputs. Ich finde automatisierte Übersetzung von Französisch ins Deutsche nicht so gut. Also sie sind einfach so wie, keine Ahnung, sie fühlen sich an wie etwas, das vor 20 Jahren cool und modern gewesen wäre und heute einfach echt holprig und so, dass man denkt, da fehlt Sinnzusammenhang.

Holger:

[2:28] Spannend, spannend.

Christoph:

[2:29] Was ist bei dir los?

Holger:

[2:32] Ja, bei mir, was ich jetzt so habe, was mich beschäftigt, ich habe vor ein paar Tagen ein Hörbuch gehört, The Triumph of Injustice, wo es so ein bisschen über, also es ist vor allem auf die USA bezogen, aber es geht über das Steuersystem. Und wie ungerecht das Steuersystem ist und auch ein bisschen darüber, dass das ja nicht naturgegeben ist, sondern auch schon mal anders war. Was? Das können Sie ja gar nicht vorstellen. Und man das auch wieder anders machen könnte.

Christoph:

[3:07] Ah.

Holger:

[3:09] Also, dass man dadurch aus der Staat sehr viel mehr Möglichkeiten hat, als in den Diskussionen gerne behauptet wird. Also zum Beispiel könnte man vielleicht für die Diskussion in Deutschland, man kann natürlich auch machen, was die Amerikaner machen und sagen, wer die Staatsbürgerschaft hat und in einem Niedrigsteuerland ist, der muss dann die Steuerdifferenz, die er dadurch spart, halt an das Land auszahlen, wo er die Staatsbürgerschaft hat. Also die Amerikaner machen das durchaus und das könnte Deutschland natürlich auch machen oder zumindest in einer abgeschwächten Form machen.

Christoph:

[3:44] Das ist schon spannend, dass die diese Art der Besteuerung haben. Ich finde, man würde denken, das Land der großen Freiheit und das Libertäre und so, da darf doch bestimmt jeder selbst entscheiden, aber dass das nicht ganz so ist, ist schon einfach interessant.

Holger:

[3:58] Ja, und vor allem auch nicht immer so war. Also es gab Zeiten, da wurde auch in den USA das Steuersystem als was gesehen, womit man… Womit man auch, ich nenne es jetzt mal Ordnungspolitik, macht. Und da gab es durchaus auch mal die Ansicht, dass es eigentlich einfach keine Superreichen geben sollte. Und das wurde dann über sehr hohe Steuern gelöst. Also ich glaube, wenn ich das richtig im Kopf habe, ich weiß nicht mehr genau, ob es Roosevelt war, ich glaube, aber es gab da einen Präsidenten, der war der Meinung, eigentlich sollte ab einem bestimmten Betrag die Steuer 100% sein, der Kongress ist da nicht ganz mitgenommen und ich glaube, da waren es 93%. Das ist schon krass. Also jedem, der hier erzählt, wenn die Steuern zu hoch sind, dann arbeitet keiner mehr und dann wirkt man damit automatisch die Wirtschaft ab. Dem muss es gesagt sein, das war jetzt keine Zeit in der amerikanischen Geschichte, wo die Wirtschaft super schwach war. Also ich glaube unter Eisenhower war das auch noch so und das war eher eine Wachstumsphase.

Christoph:

[5:06] Was das ganze Thema Kontingenz von Besteuerung angeht, finde ich, ist ja hier immer das beliebte Argument, das ich schon mehrfach gehört habe, zur Einführung der Vermögenssteuer, dass es die ja unter Kohlen noch gab und man ja nur dahin zurück wolle, so als Argument von der linken Seite.

Holger:

[5:22] Ja, und dazu kommt noch, das wurde damals durchaus vom Bundesverfassungsgericht verboten, weil die gesagt haben, die Bewertung ist nicht gleichmäßig. Und im Prinzip hat die Grundsteuerreform dieses Argument jetzt nicht nicht gemacht, weil das war vor allem auf die Bewertung von Grundbesitz bezogen.

Christoph:

[5:39] Ja, ach ja, stimmt.

Holger:

[5:42] Also eigentlich gibt es überhaupt keinen Grund mehr, das nicht zu tun. Also es gibt schon Gründe, das nicht zu tun, aber die Gründe, die einem erzählt werden.

Christoph:

[5:51] Stimmen alle nicht.

Holger:

[5:57] Aber von den Tiefen des Steuerrechts nähern wir uns dann den Tiefen der künstlichen Intelligenz. Du hast uns mitgebracht Sisyphus im Maschinenraum von Martina Hessler, Das ist ein sehr frisches Buch bei CR Beck, dieses Jahr erschienen für Menschen, die es in der Zukunft hören, 2025, und die Autorin ist Historikerin und Professorin für Technikgeschichte an der TU Darmstadt und ich muss ja gestehen Ich finde diese historischen Blickwinkel immer sehr spannend. Also ich lese auch irgendwie inzwischen lieber Wirtschaftshistoriker als Wirtschaftswissenschaftler, weil die irgendwie immer einen breiteren Blick zu haben scheinen. Deswegen bin ich jetzt sehr neugierig, wie denn die Historikerin auf die künstliche Intelligenz blickt.

Christoph:

[7:00] Ja, vielleicht als kleine Zusammenfassung vorab, bevor wir gleich dann ins Detail starten. Also Martina Hessler erzählt in Sisyphus im Maschinenraum die Geschichte einer doppelten Denkfigur oder einer Doppelfigur. Auf der einen Seite steht er im Vergleich zur Technik fehlerhafte Mensch und auf der anderen Seite sein Pendant, die vermeintlich perfekte Maschine, auch wenn sich letztere letztlich nicht als fehlerfreies, technologisch errichtetes Paradies erwiesen hat, sondern als permanente Aufgabe, an der wir irgendwie zu feilen haben. Und mit der zunehmenden Komplexität der Technik erodierte dann auch, insbesondere seit den 1970er Jahren und durch die heutige künstliche Intelligenz, das Bild der unfehlbaren Maschine.

Christoph:

[7:47] Also man merkt, dieser Maschinenbegriff, der ja auch im Titel schon vorkommt als Maschinenraum, ist bei ihr sehr, sehr stark und ich glaube, ich hatte das in irgendeiner der letzten Folgen schon mal verlinkt. Da habe ich den Artikel zur Persistenz der Argumente im Automatisierungsdiskurs aus Politik und Zeitgeschichte von 2015 oder so von ihr verlinkt und dann, genau, den hatte ich im Studium mal gelesen und dann habe ich gesehen, dass sie dieses Buch geschrieben hat und ich dachte, ah, das könnte ja zu unserer Reihe passen und du hast zumindest mal einen Text von ihr gelesen und den fandst du damals gut. Ja, so bin ich zu ihr gekommen. Und dein Argument mit den HistorikerInnen kann ich total gut verstehen. Ich finde das häufig auch sehr spannend. Manchmal ist es mir zu detailverliebt, was die machen. Das kommt dann so von Hölzchen auf Stöckchen und mir fehlt so ein bisschen der größere Bogen, aber das hatte ich hier bei dem Buch jetzt nicht das Problem.

Holger:

[8:42] Ja, dann bin ich, wie gesagt, ich bin sehr gespannt, wie sich jetzt die Details dann so zeigen.

Christoph:

[8:52] Ja,

Christoph:

[8:55] So ein bisschen, also es geht viel um Fehler und Mängel und Defizite. Einerseits, wie wurde der Mensch verstanden und konstruiert in Maschinen, also in Diskursen, die sich mit Maschinen beschäftigten. Also genau, erst im letzten Kapitel kommt sie auf, künstliche Intelligenz zu sprechen. Vorher geht es um Maschinisierung, Automatisierung, frühere maschinelle Eingriffe ins alltägliche menschliche Leben. Das ist so die eine Seite und dann das, was ich gerade schon angeteasert habe in der Kurzzusammenfassung, dieses Feststellen, dass auch Menschen, dass auch Maschinen nicht perfekt sind und dass auch die fehlerhaft sind und auch technische Systeme nicht perfekt sind und fehlerhaft sind. Haben und man da irgendwie nicht rauskommt und ja, das ist auch so dieser Gedanke vom Sisyphus, also dieses, wir optimieren immer weiter und haben die Hoffnung, wenn wir nur den einen letzten Fehler im Maschinensystem noch ausmerzen, dann müssen wir bestimmt nie wieder irgendwas machen, aber wir stellen immer wieder fest, dass sich an jede Fehlerbereinigung neue Fehler anschließen und wir damit immer wieder zu tun haben, also Also der Fortschrittsgedanke als System, was nie aufhört. Also wir kommen nie oben am Berg an, ähnlich wie Süssifus ja auch nicht. Die Frage ist nur, ob wir dann halt glücklich werden oder nicht, um das von Camus, ist es glaube ich, zu bemühen.

Holger:

[10:23] Ja, ich glaube Camus war das.

Christoph:

[10:27] Genau. Ja, vielleicht zu heute. Es geht auch so, oder es geht im Buch immer wieder um Überlegenheitsfiguren, also Maschinen und maschinelle Systeme, die als den Menschen überlegen, geframed werden. Und da kann man natürlich jetzt auch immer mal wieder sehen, dass KI als Überlegen oder den menschlichen Fähigkeiten als Überlegen erzählt wird und auch in Entscheidungssystemen ja als System gilt, was vielleicht einen kühlen Kopf bewahrt, wenn Menschen das nicht tun. Und es geht immer wieder darum, dass Menschen begrenzt sind, Intuitionen unterliegen, Vorurteile haben und die vielen Daten, die wir heute in der Gesellschaft haben, auch nicht mehr überblicken und dafür braucht man dann technische Systeme.

Holger:

[11:13] Was ich immer wieder ganz spannend finde, so als Gedanke jetzt, ist, dass wenn man mal ein bisschen guckt, ich sag mal, die Leute, die sich mit dem Thema auskennen, aber nicht selber daran basteln, die sind oft recht kritisch. Also wenn man sich so anguckt, was, ich meine, Deutschland hat ja immer noch nicht so kleine Hacker-Szene und wenn man mal ein bisschen, also ich gehöre da jetzt nicht zu, aber wenn man hin und wieder mal ein bisschen guckt, was die so sagen und was die so lesen oder mal einen Podcast da aus der Ecke hört, die sind in der Regel sehr kritisch gegenüber diesen Sachen. Die waren auch kritisch gegenüber den oder ab einem bestimmten Punkt, wo es keine Spielerei mehr war, wurden die kritisch gegenüber den ganzen Kryptowährungen und da sind auch viele kritisch gegenüber KI. Also das ist dann ja doch spannend, dass Leute sich damit besser auskennen und gleichzeitig nicht selber in der Entwicklung stecken, da durchaus oft einen kritischen Blick haben. Und ich kann mir gut vorstellen, dass das früher auch schon so war.

Christoph:

[12:17] Ja, oh, das kann sehr, sehr gut sein. Was man auf jeden Fall, glaube ich, auch sagen muss, ist, dass man ja jetzt aus dem Silicon Valley, wenn du so Leuten wie Sam Altman, von denen man halten kann, was man möchte, also für die, die ihn nicht kennen, der Chef von OpenAI, die haben ja auch so eine kritische Attitüde, die die mindestens vor sich her tragen. Ich weiß immer nicht genau, wie ernst zu nehmen die ist und wie viel die, wie viel Show die quasi einfach darstellt, aber grundsätzlich erstmal erzählen die ja auch immer wieder, wie gefährlich ihr Produkt sein könnte, wie fehlerhaft das noch ist und so, also welche, sie kommunizieren Grenzen und Limitierungen ja auch mit, also das finde ich schon irgendwie in diesem, also wenn wir jetzt KI auf Large Language Models verengen wollen, das finde ich in dem Kontext schon interessant.

Holger:

[13:05] Ja, wobei da natürlich auch noch ein bisschen, also da habe ich auch schon mal den Kommentar irgendwo gelesen, dass das auch eine Strategie sein könnte, um den Staat zur Regulierung zu bringen und die Regulierung ist dann die Hoffnung, dass die verhindert, dass neue Mitspieler in den Markt kommen. Ja, ja, ja. Also, das weiß man nicht, klar, klar.

Christoph:

[13:31] Deswegen auch mein direktes Einhegen. Ich bin mir da auch nicht so sicher wie, ja und es ist natürlich auch immer Promo. Also wenn du erzählst, oh Gott, unser neues Produkt ist so mächtig und so gefährlich, wir müssen echt aufpassen,

Holger:

[13:44] Dann wird irgendwer sagen, ah, dann muss ich das ja mal ausprobieren.

Christoph:

[13:47] Ja, das klingt schon spannend. Naja, sie startet auf jeden Fall natürlich nicht in den letzten fünf oder zehn Jahren oder so, sondern geht ein bisschen weiter zurück. Also es gibt im Prinzip drei zentrale menschliche Unvollkommenheiten, die sich so über die Jahrhunderte quasi rauskristallisiert haben und damit startet sie ein bisschen. Zum einen sind wir natürlich körperliche Mängelwesen. Das wird seit der Antike erzählt. Also unsere Körper sind unvollständig, haben Rückenschmerzen, können dieses oder jenes nicht. Also das ist auf jeden Fall was, was wir schon lange kennen. Und genau dieser Begriff des Mängelwesens wird im 18. Jahrhundert von Johann Gottfried Herder geprägt.

Christoph:

[14:37] Da geht es so richtig los, aber genau, in der Antike hatten wir das auch schon als irgendwie Topos und da ist dann ein bisschen natürlich die Frage, wie geht man damit um? Da kann man dann natürlich auf die Idee kommen, dass man sich diesen mangelhaften Organen, die wir so haben, dass man die erweitern könnte, dass man diese Mängel, die der Mensch hat, zur Seite schieben kann und beseitigen kann. Das zweite große Thema ist natürlich die Sündhaftigkeit des Menschen, die moralische Unvollkommenheit. Also sie geht da auf das Buch Genesis ein, die Geschichte von Adam und Eva, von der sie sagt, wie formuliert sie das, dass das natürlich nur eine Geschichte ist, die aber so viel Verbreitung gefunden hat, letztlicherweise, dass sie quasi als wahr gilt. Und das finde ich irgendwie ganz, ganz spannend, weil ich das bei dem Buch immer wieder mal gedacht habe, auf das wird sich so häufig bezogen, so als wäre das empirisch nachvollziehbar wirklich passiert. Das finde ich schon ganz interessant.

Holger:

[15:40] Ja, natürlich auch immer wieder spannend, dass so moralische Dimensionen ja doch immer wieder in alle möglichen Themen auch reingebracht werden. Und dann teilweise ja auch die sachlichen Punkte übertünchen. Also ich finde, das merkt man auch jetzt im Moment sehr in der ganzen Debatte um sowas wie Bürgergeld, dass das da ja sehr viel versucht wird, so moralisch zu argumentieren. Interessanterweise wird aber das immer nur in eine Richtung gemacht. Also wenn jemand irgendwie reich geerbt hat und nicht arbeitet, da wird da nix zu gesagt.

Christoph:

[16:23] Das ist sehr merkwürdig tatsächlich, ja. Aber das ist so, die Menschen sind verführbar. Das Paradies war aber ein Modell der Fehlerfreiheit, auch wenn die Menschen, die darin gelebt haben, natürlich keine, also das Paradies war fehlerfrei, aber die Menschen waren nicht frei, weil sie natürlich auch keine Entscheidungshoheit hatten. Also die Sündhaftigkeit kommt ja damit in die Welt, dass sich überhaupt mal entschieden wurde zwischen einer richtigen und falschen Entscheidung gewissermaßen. Also da gab es wenig Selbstbestimmung und im KI-Kontext ist das insofern relevant, als wir über Verantwortlichkeit und Zurechenbarkeiten auf jeden Fall sprechen müssen. So das klassische, wenn das autonome fahrende Auto einen Unfall baut, wer ist denn dann eigentlich Schuldthema?

Holger:

[17:18] Ja, beziehungsweise, was ja jetzt ja auch eigentlich schon wahrscheinlich ein relativ aktuelles Thema ist, wenn die Drohne jemanden umbringt, wer hat denn jetzt dafür die Verantwortung? Und da kann man natürlich dann auch die Frage stellen. Du hast auf der einen Seite, ich meine, wenn die noch ferngesteuert werden, dann kannst du sagen, okay, die Person, die da auf den Knopf drückt. Aber je autonomer die werden, und ich glaube, die sind schon autonomer, als man so denkt, wenn die jetzt irgendwie über einen halben Planeten gesteuert werden, haben die ja auch eine gewisse Signalverzögerung. Das heißt, irgendeine Art von Autonom, so ein gewisses Teil autonomes haben die schon. Was ist denn dann, wenn irgendwie die mal voll autonom sind?

Christoph:

[18:07] Ja, das ist tatsächlich sehr konkret, ja. Ja, und ich meine, das Autobeispiel ist, glaube ich, auch schon insofern konkret, als dass sich die Hersteller damit auseinandersetzen müssen, was sie da einprogrammieren. Das ist ja auch…

Holger:

[18:21] Ja, da gibt es auch ganz spannende Diskussionen. Ich erinnere mich dran, das war vor, ich glaube schon zwei, drei Jahre her, dann ist das mal auf so einem Nerdblog aufgetaucht, dass es da durchaus diese Frage gibt, es gibt ja dieses berühmte, wie heißt das, Trolley-Problem, wie eine Entscheidung getroffen werden soll und dass das auch sehr kulturell sein kann. Dass zum Beispiel so im Westen man sagen würde, wenn du die Wahl hast, eine alte Person oder ein Kind zu überfahren, überfahre die alte Person. Also das ist eher in unserem Denken so ein bisschen verankert. Während im asiatischen Raum da ist ein hoher Respekt gegenüber dem Alter, da wird gesagt dann überfahre das Kind ja, weil so viel Wissen verloren gehen würde bei der alten Person also das ist, das sind durchaus Fragen, wo dann wenn man sich damit beschäftigt, auch gerade solche kulturellen Unterschiede nochmal sehr prägnant werden also du meinst.

Christoph:

[19:30] Toyota löst das Problem anders als VW ja

Holger:

[19:33] Ne, also es ist ja dasselbe Auto, wenn dasselbe Auto in China verkauft wird und in Deutschland verkauft wird, gibt es da vielleicht unterschiedliche Prioritäten, mit denen gehandelt wird.

Christoph:

[19:47] Ja, also so habe ich da noch gar nicht drüber nachgedacht. Ja, spannend. Also ich meine, das ganze Thema Tugend und Verantwortungsethik und so ist eins, was so bei Trolli-Problemen auch immer mal reinkommt. Aber ja, dritte Unvollkommenheit übrigens ist die kognitive Unvollkommenheit, also Menschen irren sich und treffen Fehlentscheidungen, aber das aus Versehen, weil sie es halt nicht besser können, nicht weil sie so sündhaft sind, oder nicht nur weil sie sündhaft sind, sondern weil sie halt einfach nicht kognitiv perfekt sind. Und eine Resonanz dazu oder als Antwort darauf entstand dann im frühen 19. Jahrhundert das Bild der unfehlbaren Maschine. Das ergibt natürlich nur Sinn, wenn man in einem industriellen Kontext anfängt zu denken, weil da Maschinen natürlich in sehr routinierten Fertigungsprozessen einfach wirklich sehr wenig fehlerhaft behaftet sind Und dann kann man denken, na gut, wenn wir das doch nur übertragen könnten auf alle Lebensbereiche, dann werden wir schon eine tolle Welt zimmern können gewissermaßen. Also das ist so, das setzt da ein und ich finde das mit der Maschinisierung, Automatisierung zusammenzudenken, ergibt wirklich sehr viel Sinn. Nur so kann man verstehen, wie man denken kann, wenn wir doch nur alles mit Maschinen machen würden, dann hätten wir eine quasi fehlerlose Welt.

Holger:

[21:15] Ja, wobei ich da jetzt auch gerade den Gedanken habe, dass diese Idee wahrscheinlich von Leuten gekommen ist, die selber nicht in der Fabrik gearbeitet haben, weil ich glaube, dass es da sicher jede Menge Unfälle gab, weil so eine Maschine, die stupide einfach weiterarbeitet, egal ob da irgendwer gerade im Weg steht. Also aber das ist, passt vielleicht auch zu dem was ich eben gesagt habe, also diese idealisierten Bilder sind möglicherweise eher von Leuten, die selber nicht so direkt damit zu tun haben, ne, also oder zumindest nicht auf der Arbeitsebene damit zu tun haben und die die Risiken dann sehr gut oder die Probleme sehr gut wegignorieren können, aber hat sie irgendwas dass dazu geschrieben…

Christoph:

[22:08] Wie meinst du?

Holger:

[22:10] Also sozusagen hat sie eine Kritik schon an den Bildern des 19. Jahrhunderts in irgendeiner Form geübt, ob das dann in der Praxis wirklich so war?

Christoph:

[22:23] Das kommt später auf jeden Fall noch, aber sie zeichnet mehr nach, wie die Denkfiguren so sind und wie man so Stück für Stück auf die Ideen kommt, dass das vielleicht dann doch nicht die Lösung war. Nee, aber das an sich, sie hat jetzt nicht geschrieben, das war insofern dumm, weil es gab doch diesen, jenen und solchen Betriebsunfall hier, da und dort, explodierende Dampfmaschinen oder was auch immer. Nee, das hat sie nicht so sehr. Genau, sie kommt nochmal auf den Fehlerbegriff an sich zu sprechen. Also in der deutschen Sprache wird ja seit dem 16. Jahrhundert benutzt. Und anfangs meinte er, war damit ein Fehlschuss im Gegensatz zum Treffer gemeint. Und das wandelt sich dann so über die Jahrhunderte. Also sie nimmt da den Brockhaus, also dann irgendwie Ende des 19. Jahrhunderts ist es eine Abweichung von dem Normalen und Zulässigen bei Menschen, Tieren oder Sachen. 1930 ist es dann eine ausschließlich mathematische Fehlerdefinition und die hält sich dann auch und dann

Christoph:

[23:30] 1986 bis zur letzten Auflage ist es dann die Bestimmung des Fehlers als Computerfehler im Kontext der Datenverarbeitung und der Informatik. Also da geht es dann ganz stark um Hard- und Softwarefehler in den Definitionen, was ich irgendwie spannend finde, weil alles so kurz gedacht scheint. Also ich Ich finde es spannend, dass das jeweils so verengt wurde auf die verschiedenen Begriffe. Da sieht man dann auch so Konjunkturen einfach.

Holger:

[23:57] Naja, ich hätte jetzt auch gedacht, dass Fehler eigentlich ein recht breiter Begriff ist.

Christoph:

[24:01] Hätte ich eigentlich auch gedacht, ja. Ja.

Holger:

[24:04] Ja, das ist aber natürlich auch wieder spannend, wieso Wortbedeutungen sich mit der Zeit dann ändern.

Christoph:

[24:12] Ja, das ist in meiner Vorstellung von dem Vertrauensfragenbuch von Ute Frewert, die hat das ja ganz viel gemacht, ist das irgendwie auch spannend zu sehen, die hat das ja auch immer anhand von diesem Lexika gemacht, scheint das wohl eine gängige Methode in den Geschichtswissenschaften. Ja, das ist so der Einstieg ins Buch gewesen oder das erste Kapitel. Und dann geht sie weiter, nochmal weiter ins 19. Jahrhundert rein und da wird der Mensch als Störfaktor immer stärker beschrieben.

Christoph:

[24:50] Also der Mensch wird verstanden als Hemmnis für das Funktionieren technischer Abläufe. Also das, was ich gerade eben schon meinte mit der Industrialisierung, Maschinisierung. Es ist immer noch die Idee oder weiter die Idee, dass Technik besser funktioniert, wenn man den Menschen quasi aus der Gleichung streicht. Ich würde dem auch nicht zwingend immer wieder sprechen wollen. Also Martina Hessler schreibt immer wieder so, als würden die Gegenargumente dagegen auf dem Tisch liegen und als sei das irgendwie alles naiv und blöd. Das würde ich gar nicht unbedingt sagen. Ich kann schon verstehen, woher der Gedanke kommt, dass wenn man eine Fabrik baut, die einfach komplett nur mit Maschinen läuft, dass das im Zweifel vielleicht besser läuft, als wenn man an jedem dritten Zwischenschritt nochmal einen Menschen hat, der auch noch was machen muss und der vielleicht nicht in den Takt passt oder wie auch immer. Also ich verstehe schon, wie man zu den Gedanken kommt. Und sie schreibt immer so, als sei schon völlig klar, warum das denn so wahnsinnig blöd ist.

Holger:

[25:46] Wobei ich sagen muss, also ich oute mich jetzt gerade mal, ich gucke immer mal wieder ganz gerne die Sendung mit der Maus.

Christoph:

[25:53] Oh, das mache ich auch gerne.

Holger:

[25:56] Und da sieht man ja auch immer mal wieder, wie irgendwas in irgendwelchen Fabriken hergestellt wird. Und ich bin häufig erstaunt, an wie vielen Schritten wirklich noch ein Mensch mit seinen Händen irgendwas tut, irgendwas zusammensetzt, was anscheinend einfacher von einem Menschen zusammenzusetzen ist, als von einer Maschine. Also es ist dieses Bild, dass das alles nur noch vollautomatisiert ist, das stimmt anscheinend gar nicht mal so absolut, wie man sich das denkt.

Christoph:

[26:29] Ja, da bin ich ganz bei dir. Ich finde die Sendung mit der Maus auch, ich finde einfach so Industrieprozesse, da spricht dann vielleicht auch der Gewerkschafter aus mir, ich finde es einfach wahnsinnig spannend zu sehen, wie Dinge industriell hergestellt werden und ehrlicherweise, wer kriegt da Einblicke und darf das mal mitfilmen, das ist halt häufig die Sendung mit der Maus und dann ist es meist auch noch so erklärt, dass man es wirklich schnell versteht, also ja, ich finde es auch sehr, sehr gut.

Christoph:

[26:57] Was natürlich auf der Hand liegt, ist, dass das Ideal der mechanischen Maschine, da war das Uhrwerk, das ist der Inbegriff, also Regelmäßigkeit, Stabilität, Ordnung, Harmonie und die menschliche Subjektivität muss ausgeschaltet werden und das geht dann auch damit einher, dass man natürlich zum neuen Ideal der Objektivität in den Naturwissenschaften kommt. Das ist vielleicht auch nochmal ganz spannend, was für Prozesse so parallel laufen, also welche wissenschaftlichen Ideale sich auch raus ausbreiten.

Christoph:

[27:34] Genau, was natürlich klar ist, die mechanische Maschine glänzt immer nur da, wo es um determinierte Prozesse geht. Was ich noch ganz interessant fand, ist, was sie meinte, naja, wir haben ja eine Verschiebung in der Zeit von der handwerklichen Produktion in Kleinstbetrieben oder vielleicht auch Manufakturen, wobei ich zu dem Begriff auch noch was zu sagen hätte, aber das vielleicht nicht an der Stelle, weil der heute so romantisiert ist und das aber, glaube ich, von der Arbeitsrealität nie war, hin eben zu diesen wirklich Fabrikprozessen. Und menschliche Unregelmäßigkeiten waren in der handwerklichen Produktion erstmal keine Fehler, sondern die gehörten halt zum Produkt dazu und das war auch allgemein akzeptiert, dass halt nicht alles gleichförmig und ganz gleich aussieht. Und erst durch dieses Verschieben zu den Maschinen entwickelt sich das anders und diese menschliche, es sieht nicht immer alles gleich aus, Dinge dürfen sich unterscheiden im gleichen Produktionsprozess, wird erst da als fehlerhaft geschrieben.

Holger:

[28:40] Ich habe auch gerade noch so einen ganz interessanten kulturellen Gedanken, also das… Das ist auch so eine Sache, wo ich nicht mehr genau weiß, an welcher Stelle ich das mal gelesen oder gehört habe. Aber es ist angeblich so, dass in der islamischen Kunst es die Idee gibt, dass Perfektion Gott vorbehalten ist. Oh, spannend. immer bewusst irgendwo ein Fehler, also Anführungszeichen Fehler gemacht wird, um sozusagen darauf hinzuweisen.

Christoph:

[29:24] Das ist, finde ich, sehr spannend.

Holger:

[29:26] Ja. Also, wenn sich jetzt jemand besser mit islamischer Kunst auskennt und sagt, das stimmt alles überhaupt nicht, dann lasse ich mich da gerne korrigieren. Es ist auch so lange her, dass ich es irgendwo aufgeschnappt habe, dass ich auch gar nicht mehr weiß, wo ich es her habe. Ich finde diesen Gedanken aber sehr spannend.

Christoph:

[29:40] Oh ja, finde ich auch. Das ist tatsächlich sehr interessant. Also ja, das wäre vielleicht auch eine Kritik an Hessler. Man kann, glaube ich, schon unterstellen, das ist ein sehr eurozentrischer Blick. Also nicht als Abwertung, nicht in diesem abwertenden Motiv, aber es ist ein starker Blick, glaube ich, auf deutsche, vielleicht europäische Kulturgeschichte. Ich würde fast sagen, selbst der US-amerikanische Raum kommt nur sehr begrenzt vor, also kommt notwendigerweise dann später, wenn es um KI geht, aber die Denkfiguren sind schon sehr mitteleuropäisch, würde ich sagen.

Holger:

[30:20] Was ich persönlich auch erstmal unproblematisch finde, solange das halt klar kommuniziert ist. Ja, absolut. Also, dass Historiker ja oft einfach ein bestimmtes Gebiet haben, auf das sie sich konzentrieren, mit dem sie sich auskennen, liegt, glaube ich, in der Natur der Sache. Also, ich würde jetzt auch nicht erwarten, dass deutsche Historiker eine tiefe Kenntnis des Geschehens in Korea haben.

Christoph:

[30:44] Ja, ja, ja, das ist wahr. Nee, ich finde es auch nicht dramatisch, nee.

Holger:

[30:49] Ist natürlich schön, wenn sie zumindest einen groben Überblick haben, aber dass sie da in den Details drin stecken, das wäre jetzt auch gar nicht meine Grunderwartung.

Christoph:

[30:59] Was an Maschinen natürlich toll ist oder an Robotern, die arbeiten ohne Licht, Wärme und Arbeitspausen, sie sind schnell, fleißig, zuverlässig und genau, ganz anders als wir es so sind. Also, ja, es gibt dann auch…

Holger:

[31:13] Ja, aber sind natürlich dadurch auch, Entschuldigung, wenn ich da kurz eingehetschen darf, dadurch sind sie natürlich auch unflexibel.

Christoph:

[31:20] Ja, genau, das wird dann später irgendwann, geht das den Menschen auch mal auch, aber das sind so die Hoffnungen im 19. Jahrhundert und damit wird beschrieben, wie so die Wahrnehmung ist. Man hat irgendwie auch so ein bisschen, ich finde, also von heute aus vielleicht merkwürdige Anwandungen, dass Streitigkeiten und Konflikte, durch eine technische Instanz aufgelöst werden könnten. Also, dass man da irgendwelche mechanischen Apparate bauen könnte, die dann irgendwie Wahrheit finden könnten und damit kommt man um Konflikte hinweg. Also, schon irgendwie sehr, sehr interessant.

Holger:

[31:55] Finde ich jetzt ehrlich gesagt aber gar nicht so abwegig, weil es gibt ja auch Leute, die sagen, dass man irgendwelche KI-Richter in der Zukunft einsetzen könnte. Das klingt für mich eigentlich wie dasselbe.

Christoph:

[32:07] Ja, genau, das sind die gleichen Fantasien, die sich da spiegeln, das ist auf jeden Fall. Dann hat man so auch Unfähbarkeitsmythen, also die Rechenmaschine von Leibniz zum Beispiel, der ist ganz begeistert, weil die keinen Fehler am Rechnen macht, solange die Maschine nicht bricht. Das Problem seiner Maschine war, sie ist andauernd gebrochen, weil sie so kompliziert war. Aber wenn doch nur die Maschine gut wäre, dann hätte man das ja gelöst.

Holger:

[32:38] Wobei auch da gibt es Einschränkungen. Ich hatte gestern bei der Arbeit so ein kleines Problem mit Excel, wo… Wo das irgendwie eine Zahl nicht ausgerechnet hat und bis ich dann irgendwie mal gefunden hatte, warum, da habe ich festgestellt, ah, okay, Excel kennt nur noch die reellen Zahlen, was für diese Anwendung auch korrekt war. Aber sozusagen rein mathematisch hätte man das lösen können, wenn man komplexe Zahlen kennen können würde. Also das Ergebnis hätte da keinen Sinn ergeben, insofern war das okay. Aber da sieht man dann, die Rechenmaschine kann auch nur das, was der Rechenmaschine eingegeben wurde, zu lösen. Und Probleme, die dann nicht, sozusagen die außerhalb seines Horizonts sind, kann es halt nicht lösen. Während ein Mensch vielleicht irgendwie auf die Idee kommen könnte mit einem Trick, kann man das dann vielleicht doch noch.

Christoph:

[33:36] Sowas finde ich interessant. Spannend. Also Echse ist ja eh eine eigene Hölle, aber gut, ich bin auch mathematisch nicht versiert, aber ich habe keine große Affinität zum Programm, das kann ich sagen. Wir machen einen großen Sprung, sie klappert so ein bisschen ab, was für Denkfiguren es noch gab. Also nach dem Zweiten Weltkrieg wissen wir ja alle, naja, Atomkrieg ist möglich und wäre doof. Und da hat man natürlich Sorgen, dass die Menschen, die dann als irrational und unzuverlässig und subjektiv wahrgenommen werden, mit diesen großen Entscheidungen im Zweifel betraut sind. Also da geht es darum, dass man die Unzulänglichkeiten des menschlichen Gehirns werden da stärker ausgelotet und im Diskurs nach vorne gestellt. Also so ein bisschen die Maschine, die uns über den Kopf wächst, gewissermaßen. Wir können uns gegenseitig mit nur zwei Knöpfen vernichten, die komplette Menschheit und das überlassen wir offensichtlich keiner Maschine, sondern Menschen. Ist das nicht vielleicht gefährlich? Und dann hat sie hier, wie heißt der …

Holger:

[34:52] Stanley Kubrick?

Christoph:

[34:53] Nee, der russische Offizier-General, der gesagt hat, nee, ich glaube nicht, dass das ein Atomangriff ist.

Holger:

[35:01] Ich weiß auch nicht mehr, wie er heißt.

Christoph:

[35:04] Petrov? Ja, Petrov. Ja, es ist Petrov, der den Fehlalarm erkennt.

Holger:

[35:11] Der war ein Oberst, glaube ich. Naja, aber das ist ja dann wieder ein Hinweis darauf, dass das vielleicht reines Vertrauen auf die Technik dann doch nicht die beste Idee ist.

Christoph:

[35:24] Ja, genau. Und sie zeichnet ihn auf jeden Fall auch nochmal explizit nach und spricht über ihn. Aber naja, erstmal ist so ein bisschen das Thema, oh Gott, wir haben diese Möglichkeiten und wir haben Menschen, ob das so gut ist, eine ganz kluge, clevere Maschine, ein Computersystem wäre doch vielleicht besser und unfehlbar und man wüsste wirklich und so.

Holger:

[35:42] Mir fällt da jetzt auch noch ein Beispiel ein von Stanley Kubrick, deswegen sagte ich den Namen gerade, gibt es ja diesen Film Dr. Seltsam, wo genau das ja auch irgendwie mit drin steckt, also die Maschine, die dann, wo man gar nicht mehr eingreifen kann, ich glaube in dem Film ist es dann ein Mensch, der es auslöst, aber dann gibt es halt auch kein Zurück mehr. Also das ist natürlich auch wieder ein Argument für die Künste, auch jetzt gesagt als jemand, der eigentlich eher aus der, weiß ich nicht, aus der harten Naturwissenschaft kommt, aber es ist auch wieder ein Argument für Künste, dass solche Themen da ja dann auch nochmal auf eine andere Art dargestellt und verhandelt werden können.

Christoph:

[36:29] Ja, das ist sicher eine wichtige Funktion, wenn man so sagen will, von Kunst, das stimmt. Ein wirklich langer Teil im Buch behandelt den fehlerhaften Mensch im Automobil, weil da natürlich der fehlerhafte Mensch ganz besonders zutage tritt. Und jede Person, die ab und zu Auto fährt, weiß das. Man ist sehr konfrontiert mit den Unzulänglichkeiten anderer. Und Menschen verschaffen sich da ja auch durchaus Luft in ihren Gemütszuständen.

Holger:

[37:00] Wenn man ehrlich ist, macht man natürlich selber auch wieder Fehler.

Christoph:

[37:05] Das kann ich mir gar nicht vorstellen. So kann das nicht sein. Aber erst gilt der Autofahrer als Sünder, besonders in den 1950er und 60er Jahren. Und es gibt so eine Obsession mit Ordnung. Also die Menschen sind fehlerhaft, weil sie Regeln verletzen, also sehr viel Intention wird unterstellt und schon in den 50er Jahren war automatisches, wie es damals noch hieß oder dann heute autonomes Fahren, so ein bisschen das Ziel, der Wunsch, dass man da…

Christoph:

[37:34] Von weg kommen kann und auch heute kennen wir ja den Wunsch danach und sowas wie Unfallzahlen sollen durch autonomes Fahren um 80 bis 95 Prozent gesenkt werden, weil das Problem immer bei Menschen gesehen wird. Und auch hier, das wäre so eine Kritik an Hessler von mir, formuliert sie das so, als sei das falsch, also als sei das einfach nicht empirisch vielleicht richtig und nachweisbar, dass wenn wir Kontrolle an autonome Fahrsysteme abgeben, das Fahren tatsächlich sicherer wird oder was ich mir gut vorstellen kann, sind so Kolonnenfahrten auf Autobahnen, da autonomes Fahren stärker und dann hast du da höheren Verkehrsfluss, weil du diese ganzen Bremses, also dieses Abbremsen und so nicht hast, also ich verstehe, wo sie herkommt gedanklich und das ist auch irgendwie interessant, aber ehrlicherweise an manchen Stellen sind ja Sintmaschinen, die Menschen auch einfach überlegen und das zuzugeben hier und da, wäre auch okay gewesen für mich. Also ja, ich habe ehrlicherweise vielleicht aber auch große Hoffnung ins autonome Fahren und freue mich da drauf, wenn das irgendwann in der Breite Fuß fasst, weil ich mir irgendwie gut vorstellen kann, dass es eigentlich ganz cool ist, nicht so viel aktiv fahren zu müssen, sondern sich auf gut funktionierende Systeme verlassen zu können.

Holger:

[38:52] Ja, wobei, also jetzt, wo der Punkt aufgekommen ist, also ich bin auch immer davon ausgegangen, ja klar, das ist sicherer etc.

Holger:

[39:04] Jetzt habe ich aber gerade den Gedanken, warum glaube ich das denn und wer sagt mir das denn?

Holger:

[39:10] Und sind die Leute, die mir das sagen, sind das nicht auch die Leute, die damit Geld verdienen wollen? Das heißt, die Frage, die sich mir gerade stellt ist, wie klar ist es eigentlich, ob das so ist? Also jetzt für den Fall auf der Autobahn in einer Kolonne, wenn sich da alle eingefädelt haben, glaube ich sofort, dass das sicherer ist. Und ich muss sagen, in der Stadt, wo da viele Leute rumlaufen etc., wenn ich da mal so drüber nachdenke, bin ich da ehrlich gesagt nicht mehr sicher. Also das sind ja so Sachen, wo man immer wieder feststellt, was für Probleme da die, wenn wir über Kognition vorhin geredet haben, was für Probleme dann so die existierenden autonom fahrenden Autoprojekte, was für Probleme die mit Erkennen von Situationen haben, wo man dann sagen muss, ein Mensch erkennt das eigentlich in der Regel.

Holger:

[40:06] Oder wenn, dann ist es ein einfacher Fall, dass es ein Mensch nicht erkennt, aber wenn die Software einfach nicht in der Lage ist, bestimmte Szenarien richtig einzuschätzen, dann würden die ja immer zu einem Unfall führen. Das heißt, so klar, jetzt wo ich mal drüber nachdenke, so klar finde ich das gar nicht mehr. Wie gesagt, bestimmte Situationen vollkommen d’accord, weil Autobahn, das ist ja im Prinzip so, als wäre es ein Zug. Glaube ich auch sofort, aber wenn wir so in die Stadt kommen oder auch ich lebe jetzt ja auch so ein bisschen ländlicher wenn man dann die Landstraßen mit einem bezieht.

Holger:

[40:44] Weiß ich jetzt nicht also ob jetzt ein autonom fahrendes Auto ob das dann nicht denkt, ah ja an dem Radfahrer komme ich auf jeden Fall vorbei also ich hatte da neulich eine Situation wo da jemand ein Radfahrer etwas knapp überholt hat und mir entgegen kam, das war dann ein Mensch, der hat da offensichtlich eine Fehlentscheidung getroffen oder eine schlechte Entscheidung, wo die am Ende glimpflich ausgegangen ist, wie eine KI das jetzt behandeln würde, das finde ich gar nicht so klar, muss ich gestehen. Und da wäre es dann nämlich die ganze Kolonne gewesen, die versucht hätte, diesen Radfahrer zu überholen. Und das wäre für mich ein unlösbares Problem geworden.

Christoph:

[41:25] Ja, fair. Ja, vielleicht bin ich da auch zur Technik, glaube ich, ich weiß es nicht. Aber genau so eine Eingrenzung fehlt an der Stelle vielleicht bei Hessler im Buch. Also, dass man sagt, naja, man kann sich das hier oder da gut vorstellen und wer promotet das denn quasi, sondern es liest sich alles wie, naja, das liegt doch auf der Hand, dass das nicht so toll sein wird wie versprochen. Und da denke ich so ein bisschen, naja, ein bisschen Tiefenbohrung vielleicht hätte da an der Stelle nochmal gut getan. Aber ja.

Holger:

[42:00] Das ist sicherlich immer so. Wobei natürlich, also ich weiß nicht, ob sie irgendwas zu ihrer Intentionen… Mit dem Buch formuliert hat. Manchmal sind so Sachen ja auch absichtlich ein bisschen zu scharf formuliert, um einen Gegenpol zu bilden.

Christoph:

[42:18] Ja, in H&DAS, so die Gegenpolbildung ist gar nicht so stark, sondern es ist mehr dieses Nachzeichnen davon, dass Autofahrende einfach immer als Fehler im System gelesen werden und das auch immer noch so getan wird. Und ich würde halt immer sagen, ein Stück weit sind sie es, glaube ich, auch. Also ich glaube, an dem Argument ist einfach was dran, zu sagen, Menschen sind diesbezüglich, wenn man so möchte, fehlerhaft oder Menschen sind halt menschlich, das würde vielleicht auch reichen und deswegen ist da eine gewisse technische Unterstützung schon befürworten.

Holger:

[42:51] Ja, wobei auch da teilweise, ich will mich jetzt nicht zu sehr festbeißen, aber nur noch kurz als Bemerkung, teilweise gibt es natürlich auch Probleme, die kommen jetzt dann auch wieder von der Technik und da kann der Mensch dann nichts dran tun. Wenn du den Fall hast, dass sich irgendwie der Hitzesensor im Motor denkt, dass es überhitzt, weil der Sensor kaputt ist und dein Motor abschaltet, während du gerade auf der Straße fährst, dann kannst du als Mensch nichts tun. Dann blockierst du jetzt die Straße wegen der Technik. Also da muss man dann auch sehen, was ist denn jetzt wirklich der Fehler des Menschen. Und ich würde auch sagen, der Mensch macht mehr Fehler im Zweifel, aber auch nicht alles, was vielleicht jetzt als menschlicher Fehler gelesen wird, ist dann wirklich Fehler des konkreten Fahrers, sondern teilweise auch ein Fehler der Technik, mit der er denn fahren muss.

Christoph:

[43:50] Ja, das stimmt. Ja, den einen Punkt überspringe ich aus Zeitgründen mal. Was sie auf jeden Fall nochmal rausstellt, ist, dass das Einschreiben von Moral in Maschinen eine lange Geschichte hat. Und was sie damit meint, ist, dass Maschinen zur Normierung und Verhinderung von Fehlverhalten, das ist so die eine Sache, die wir schon lange kennen und das finde ich erstmal interessant. So habe ich glaube ich noch nicht drüber nachgedacht. Also zum Beispiel der Sicherheitsgurt ist ja eine Einschreibung gesetzlich davon, wie wir uns vorstellen, wie zu fahren ist und das kann man technisch halt direkt umsetzen und in zumindest modernen Autos ja nur mit sehr viel Nerv kann man sich darüber hinwegsetzen. Also dann piept ja so ein modernes Auto und sagt ja die ganze Zeit schneide ich jetzt an, schneide ich jetzt an, schneide ich jetzt an. Ich glaube, dass sie noch nicht losfahren, soweit sind wir nicht, aber das könnte man sich ja zum Beispiel auch vorstellen. Andere Stellen, die ich wirklich vielleicht konkret problematischer oder spannender noch finde, sind so Sachen wie der Einsatz von Lügendetektoren im Rechtssystem.

Christoph:

[45:02] Ich weiß gar nicht, ob das noch so ist. Also da referenziert sie die USA auf jeden Fall stark. Ich kenne das zumindest hier aus unserem Kulturkreis nicht so sehr. Da wurde gerade am Anfang häufig darauf gesetzt, dass man, naja, wir haben jetzt Lügendetektoren und wir vertrauen denen einfach ziemlich stark, ob Menschen jetzt die Wahrheit sagen oder nicht. Und das ist natürlich, einerseits kann man darüber sprechen, ob Lügendetektoren das so zuverlässig hinkriegen, wie man glaubt, dass sie es können. Und zum anderen ist es ja auch, gerade wenn es um Zeugenaussagen geht oder hast du Tat XY verübt oder nicht, kennt es ja überhaupt keine Grauschattierung. Also da ist man ja in einem sehr starken Wahr-Falsch-Muster und menschliche Beurteilungen würden vielleicht sagen, naja, das ist in Teilen richtig, das ist in Teilen glaubhaft, vielleicht gibt es irgendwas, was vergessen wurde, was verzerrt wurde, aber man kommt in sehr binäres Denken auf jeden Fall rein, sobald man sich auf solche Techniken verlässt. Das finde ich spannend.

Holger:

[46:05] Und es ist ja auch, glaube ich, so, dass es auch zumindest starke Hinweise gibt, dass Lügendetektoren nicht vertrauen.

Christoph:

[46:12] Genau, das wäre die viel fundamentalere Kritik, aber die Art und Weise überhaupt mit Technik quasi beurteilen zu wollen, ist in einem sehr starken, richtig falsch Schema verhaftet. Also, ja.

Holger:

[46:27] Ja, wo man natürlich auch sagen könnte, das ist vielleicht auch so ideengeschichtlich ein bisschen so mit der Aufklärung gekommen, dass man dann viele Sachen sehr in so Schemata einteilt. Also es ist ja genauso auch mit der Art, wie man mit… Ja, wie man mit geschlechtlich nicht eindeutig geborenen Personen umgeht, wo es im Mittelalter, ich hatte da vor vielen Jahren mal einen Podcast drüber gehört, wo das auch am Rande vorkam, dass man im Mittelalter sehr viel natürlicher damit umgegangen ist. Und eigentlich diese Einteilung, ich muss das klar einteilen, dann eher ein Resultat der Aufklärung war, das gesagt hat, ja, zwei Geschlechter, und das muss irgendwie reinpassen, während vorher halt ein gewisser Pragmatismus im Umgang damit geherrscht hat.

Christoph:

[47:21] Interessant.

Holger:

[47:23] Und das kann ich mir auch schon gut vorstellen. Und interessanterweise ist jetzt die Wissenschaft oder die Naturwissenschaft in vielerlei Hinsicht wieder an dem Punkt, wo diese Komplexität wieder reinkommt und irgendwie, dass es eben nicht immer so binär ist. Aber das hat halt auch gedauert. Und also in der Physik zum Beispiel, wir haben jetzt 100 Jahre Quantenmechanik, wird im Moment gefeiert. Das war ja auch ein Prozess, wo die Leute sich erst mal irgendwie darauf einstellen mussten, dass die Sachen nicht so klar sind in diesen klaren Schemata. Und das ist vielleicht auch was, wo ich manchmal denke, Ja, also bei manchen Sachen sind die Menschen früher viel pragmatischer damit umgegangen und vielleicht würde uns manchmal dieser Pragmatismus auch wieder gut tun.

Christoph:

[48:14] Oh ja, Thema Pragmatismus. Ich wollte es eigentlich nicht reinnehmen, aber es passt zu gut da rein. Sie erzählt eine Geschichte, da war sie an einem Flughafen und wollte ihren Koffer aufgeben und es gab nirgendwo, standen irgendwelche Menschen. Es war einfach, du gibst den selber auf, es gibt eine Waage und der war 500 Gramm zu schwer bei irgendwie Langstreckenflug. Und sie meinte, naja gut, mir ist dann irgendwie nichts übrig geblieben, ich musste letztlich, keine Ahnung, Sachen da rauspacken und so weiter und sie hätte, ich kriege es gerade nicht ganz zusammen, aber aus irgendeinem guten Grund hätte sie gerne mit einem Menschen einfach drüber gesprochen, weil ich weiß nicht, ob sie schon drei Jacken anhat oder so, keine Ahnung, ich kriege es nicht zusammen. Der Punkt ist ein bisschen zu sagen, da ist eine Maschine, die hat einprogrammiert, du darfst halt 23 Kilo und nicht 23,5 oder was auch immer und die Maschine ist quasi völlig autoritär. Also du kannst an ihr überhaupt nicht vorbei. Du kannst ja manche Dinge mit Maschinen schlicht nicht verhandeln, weil da eine einprogrammierte Regel ist und die ist halt umzusetzen, fertig. Genau, und ich finde, das passt da ganz gut dazu, dass sie meinte, naja, vielleicht mit einem Flughafenmitarbeiter, der bei einem Langstreckenflug gesagt hätte, ach, 23,5 ist doch wurscht, hier einfach durch und fertig, dass sowas halt völlig wegfällt, wenn man diese Entscheidung Maschinen überlässt, weil die halt einfach keinen Spielraum in ihren Entscheidungen haben. Ja.

Holger:

[49:38] Ja, es wird in gewisser Weise entmenschlicht.

Christoph:

[49:41] Ja. Ja. Also mit Verweis auf Sigmund Baumann, weil ich den einfach, also sie verweist auf Sigmund Baumann und konkret auf Moderne und Ambivalenz, was ich in Folge 21 hier schon vorgestellt habe. Deswegen nehme ich das nochmal auf. Beschreibt sie die Obsession der Moderne als Streben nach Ordnung, Regelhaftigkeit, Präzision und Eindeutigkeit. Und die mechanische Maschine ist dafür ein Stück weit das Sinnbild und damit einhergeht eine Abwertung des Menschlichen, also weil das Menschliche als chaotisch, unberechenbar und irrational gilt. Nach diesem Abschnitt geht sie dann über in die Moderne quasi und kommt im 20. Jahrhundert an und da werden dann die Tücken des fehlerhaften Menschen schon ein bisschen mehr präsenter. Genau, und sie sagt, naja, die Überwindung menschlicher Fehler und Grenzen, das ist das, was ich am Anfang meinte, zieht immer weitere Technisierung nach sich, was wiederum neue Fehler und Grenzen produziert. Also man hat so eine endlose Steigerungslogik, ich meine, die kennen wir aus verschiedenen Bereichen des Kapitalismus vielleicht auch einfach.

Christoph:

[50:54] Genau, also um den Begriff des Sisyphus nochmal aufzugreifen, der erfindet technische Mittel, um den Stein, also seine Aufgabe, leichter, schneller und perfekter zu bewältigen, aber die einfache Gleichung der maschinellen Lösung funktioniert einfach nicht. Also wir haben so eine Sisyphus-hafte technologische Steigerungs, weiß ich nicht, ob Epidemie der richtige Begriff ist und auf jeden Fall ist diese Steigerungsidee einfach endlos und ja, sie spricht dann nochmal über das Auto, davon, da gehen wir nicht so tief drauf ein, aber im Prinzip ist das für sie, der Mensch wird da zum Cyborg, zum elektronisch verbesserten Autofahrer und zum fahrenden Superhuman, Weil man besser hört, besser sieht mit den Autoassistenzsystemen. Ich weiß nicht genau, ob ich da so mitgehen würde, weil irgendwie begreife ich andere Entwicklungen der Technik cyborghafter als das Auto, aber naja, sie führt es eben auf. Was auf jeden Fall auffällig ist, und da zitiert sie Kennedy aus 1961, ist, dass die steigende Informationsmenge der modernen Gesellschaft so ab der Mitte des 20. Jahrhunderts als nicht mehr bewältigbar erlebt wird. Also Regieren zum Beispiel erreicht einen Komplexitätsgrad beyond the comprehension of men, so sagt Kennedy das.

Holger:

[52:19] Entschuldigung, welcher Kennedy?

Christoph:

[52:21] John F.

Holger:

[52:22] Okay.

Christoph:

[52:23] Ja.

Holger:

[52:25] Genau.

Christoph:

[52:27] Ja, guter Einwand, aber ja, genau, John F. Bin ich jetzt nicht völlig, nee, ist der Präsident. Also so ein bisschen die Idee, dass Menschen mit so einer Steinzeitmentalität und allen Unzulänglichkeiten zu langsam und zu kurzsichtig durch die Welt navigieren, die eigentlich total komplex geworden ist.

Christoph:

[52:51] Und ja, da entwickeln sich dann irgendwann so Expertensysteme, Ein bisschen die Hoffnung, dass man Computer mit ganz viel Information füttern kann und dann vielleicht noch kluge Menschen aus dem Themenfeld dazu holt und die gelten aber schnell als gescheitert, weil es viel zu aufwendig war, sämtliches Wissen in Computersysteme einzuspeisen oder auch in Bücher am Anfang und die quasi up to date zu halten. Also das, was wir heute irgendwie als Paperflut aus der Wissenschaft kennen und dass es total schwierig ist, in der Breite, in einem Themenfeld quasi auf Stand zu bleiben. Ja, und dieses komplexe und implizite Wissen eines Experten in irgendwelche regelhaften Formeln zu übermitteln oder überfordern, war auch total schwierig. Ja, also das hat auf jeden Fall nicht so richtig geklappt. Da hatte man offenbar erst große Hoffnungen drin.

Christoph:

[53:50] Ja, man stellt fest, man hat auf jeden Fall mit einem sehr großen Wissensfundus einfach zu tun und wie man mit dem umgehen soll und den Informationsmengen, das wird zunehmend zum Problem ab der Mitte des zweiten Jahrhunderts. Es tritt dann die Human-Factors-Forschung auf den Plan, die eben mit der Erkenntnis antritt, naja, die Technik ist zu komplex geworden, als dass die menschlichen Kapazitäten reichen würden, um sie quasi zu überblicken und zu bedienen. Und die Human Factors-ForscherInnen nehmen die Menschen aber in Schutz gegen

Christoph:

[54:25] Und probieren so eine gewisse Akzeptanz der menschlichen Grenzen einzufordern und quasi die Maschinen stärker an den Menschen anzupassen und die Systeme, die wir haben.

Holger:

[54:39] Ich habe auch gerade irgendwie noch mal so den Gedanken, dieses mit dem, man kann das nicht mehr überblicken, Das ist ja eigentlich auch kein neues Phänomen. Also ich glaube jetzt selbst, wenn man irgendwie so einen der Universalgelehrten der Vergangenheit nimmt, wo immer gesagt wird, ja, der wusste noch alles, dann denke ich mir immer, nee, also der kannte garantiert nicht alle Sprachen, von denen er schon mal gehört hatte, also konnte er garantiert nicht sprechen. Und ich gehe davon aus, dass auch die wenigsten dieser Universalgelehrten irgendwie, wenn sie bei irgendeinem Handwerker reingegangen wären, dann hätte dann alles verstanden hätte, was dieser Handwerker macht, sondern wahrscheinlich nur einen sehr oberflächlichen Blick hat. Deswegen denke ich, das ist eh immer so ein bisschen eine Illusion, dass das überhaupt irgendwann mal möglich war. Klar, wenn du jetzt irgendwie in einem kleinen Stamm lebst, dann ist es vielleicht für dich möglich, alle Fähigkeiten zu überblicken, die irgendwer in dem Stamm hat. Wobei ich mal behaupten würde, in dem Moment, wo du irgendwie in sowas wie einem Dorf oder so wie einer Stadt bist, da ist es eigentlich unmöglich, dass du mehr als nur einen groben Überblick hast, was die Leute eigentlich alle so unterschiedliche tun und an Wissen haben. Also einfach mal so als Einwand reingeworfen.

Christoph:

[55:58] Finde ich einen sehr guten Einwand. Die Humans Factor Leute, Menschen, ForscherInnen, wie auch immer, sind auf jeden Fall der Meinung, dass Menschen und Maschinen komplementär aufeinander bezogen und gestaltet werden müssen. Und was ich ganz witzig finde, ist, naja, sie kommen auf den Gedanken, dass es vielleicht günstiger ist, die Technik an die menschlichen Fähigkeiten anzupassen, als den Menschen immer weiter aufzubauen und vielleicht zu diesem unfassbaren Cyborg zu machen. Das sei dann doch sehr teuer. Deswegen müsste man zusehen, dass die Maschinen quasi den Menschen zugänglich sind und verständlich. Und so langsam bricht sich da auch Bahn. Man kennt die ersten Computerfehler und so, das kommt gleich noch, dass auch Maschinen einfach nicht perfekt zu gestalten sind. Und damit geht es dann noch weiter. Also sie startet dann nochmal explizit in die 1970er Jahre rein, was häufig als spätmoderne charakterisiert wird, Oder zweite Moderne ist auch so ein Begriff. Da sind sich irgendwie die Leute, die sich damit beschäftigen, recht einig, dass in den 70er Jahren nochmal viel losgebrochen ist und sich da nochmal auf technischer Seite viel verändert hat.

Christoph:

[57:13] Und ja, so langsam dringt da nämlich der fehlerhafte Computer als Gefahrenquelle in den Diskurs. Also da kommt der Soldat Petrov, den wir am Anfang jetzt schon mal besprochen haben, der gesagt hat, oh, irgendwie mein Bauchgefühl sagt mir, das ist kein Nuklearangriff der US-Amerikaner, sondern das muss ein Computerfehler sein. Und da stellt sich dann raus, naja, okay, alles klar, also vielleicht ist so manchmal menschliches Wissen, menschliche Intuition, menschliches Zögern kann überlegen sein und naja, so das, was wir halt, Technik kann Fehler machen, das, was heute so klar erscheint.

Christoph:

[58:00] Und man kommt dann auch zu dem, also Charles Perrault wird da nochmal zitiert, der in den 80ern sagt, es gibt halt normal accidents, also technische Katastrophen sind jederzeit möglich, weil die Komplexität von großtechnologischen Systemen dazu führt, dass kleine banale Fehler zusammenwirken und zu Katastrophen führen können. Und man kommt dann auch endlich, würde ich sagen, zu dem Punkt zu sagen, naja, maschinelle Fehler sind irgendwie immanent und unvermeidbar. Ja, dass der Mythos der Unfähbarkeit der Computer zerbricht dann so langsam, weil man feststellt, ah, Hard und Software lassen sich nicht perfekt gestalten. Weil das kollektive Arbeiten in Gruppen an Software-Systemen macht sie zum einen besonders fehleranfällig, weil verschiedene Menschen daran zusammenwirken. Häufig sind die vielen Zeilen Code dann auch nicht mehr direkt nachvollziehbar.

Christoph:

[58:54] Was sie aber meint, das hast du ja auch angeführt, dass Leute, die sich auskennen, sehr kritisch auf manche Prozesse blicken, dass das Bild der perfekten Maschine in der Öffentlichkeit aber kaum erodierte. Das kann ich jetzt nicht so richtig belegen oder auch nicht, aber ich finde es auf jeden Fall spannend. Das wurde vielleicht ein bisschen anders mit dem Millennium-Bug, also der Sorge danach, was passiert, wenn die Computerdatensysteme das erste Mal wieder auf 0,0 umstellen. Das hatte ja einen guten Grund, dass man früher nicht die vier Stellen in Daten einprogrammiert hat, also nicht gesagt hat, wir sind bei 1972 oder was auch immer, sondern einfach nur gesagt hat, wir sind bei 72, weil man wenig Speicherplatz hatte. Aber man erlebt dann, okay, wir haben das alle so programmiert und wissen nicht so richtig, was passiert, wenn wir das nächste Mal wieder bei einem quasi, ja, bei einem Wechsel ankommen und dann Zahlen doppelt vergeben werden könnten. Mal schauen, was das mit uns macht. Ja, und da merkt man, also da wird dann offenbar sichtlich, dass digitale Gesellschaften sehr, sehr abhängig sind von Voraussetzungen, die man irgendwann vielleicht mit guten Gründen so gelegt hat, wie man sie gelegt hat, aber ja, man hängt dann vielleicht an den Entscheidungen von früher fest.

Holger:

[1:00:16] Wobei natürlich dadurch, dass das Millennium-Bug-Problem ja rechtzeitig erkannt und auch größtenteils gelöst war, ist es dann wahrscheinlich doch nicht so in der Breite der Gesellschaft wirklich angekommen.

Christoph:

[1:00:32] Aber ich würde sagen,

Holger:

[1:00:32] Ich muss gestehen, ich hätte jetzt, ist jetzt bei mir auch, also ich erinnere mich jetzt dran, wo du es ansprichst, aber es ist jetzt nichts, was bei mir so ein Gedanke aufgekommen wäre.

Christoph:

[1:00:44] Ja, das verstehe ich auf jeden Fall. Ich würde aber zumindest sagen, von dem Millennium-Bug haben viele Menschen schon mal gehört. Vielleicht haben sie es nicht im Alltag präsent, aber wenn man ihn erwähnt, dann holt man damit, glaube ich, was hervor.

Holger:

[1:01:02] Ja, aber ich glaube, damit das sozusagen ein Umdenken gegenüber dieser Unfehlbarkeit der Maschine gibt, da hätte das halt schieflaufen müssen. Also da hätte, das ist glaube ich eher das Problem, dass man… Einfach nicht so ein bewusstes Beispiel hat. Beziehungsweise, wenn, dann ist es, ach ja, das war ja ein Unfall. Das war ja ein Einzelfall. Und ich glaube, wenn man mehr direkt damit zu tun hat und mehr auch, ich sag mal in Anführungszeichen, es besser weiß, als die Maschine, dann hat man mehr Bewusstsein dafür. Und das ist halt wieder der Punkt. Leute, die viel damit zu tun haben

More Episodes

All Episodes>>Create Your Podcast In Minutes

- Full-featured podcast site

- Unlimited storage and bandwidth

- Comprehensive podcast stats

- Distribute to Apple Podcasts, Spotify, and more

- Make money with your podcast